Comment cela est-il possible ? Comment peut-on avoir une machine qui peut réussir l’examen du barreau, écrire du code, parler couramment 50 langues et pourtant ne pas être capable de détecter de nouveaux schémas, oublier ce qu’elle faisait cinq minutes auparavant, ou réécrit parfois exactement le même résultat ?

Est-ce que, malgré l’avènement de l’IA, l’humain restera au centre du jeu ?

Quelle est son fonctionnement, ses capacités … globalement, quelles sont les limites de l’IA ?

Les LLMs dépassent la cognition humaine… mais seulement jusqu’à un certain point !

Les LLMs sont conçus pour traiter et synthétiser d’énormes volumes d’informations, et ils le font avec une efficacité stupéfiante. Ils peuvent passer des examens du barreau, écrire du code et converser dans des centaines de langues. Ces systèmes sont extraordinaires lorsqu’il s’agit de manipuler des données dans des contextes prévisibles et structurés. Ce qui les rend particulièrement pertinents dans l’automatisation des tâches.

Les modèles de langage massifs (Large Language Models) actuels montrent des prouesses impressionnantes dans des tâches spécifiques, et surpassent même les capacités humaines dans certains domaines comme le traitement du langage naturel ou l’analyse de données massives.

Cependant, leur intelligence semble limitée lorsqu’il s’agit de comportements intuitifs, une zone où pourtant, même les animaux à faible cognition comme les chats les surpassent.

Les limites de l’IA ? L’intuition, la flexibilité cognitive et la capacité à détecter des schémas nouveaux échappent encore à ces modèles. L’IA peut oublier ce qu’elle faisait juste quelques moments auparavant, écrire la même fonction de code deux fois sans le réaliser, ou halluciner des étapes complètes lorsqu’on lui demande d’accomplir une tâche ouverte dans le monde réel.

Mais pourquoi un chat semble-t-il plus intelligent ?

Les cerveaux des mammifères, et donc des chats, sont biologiquement évolués pour traiter l’information d’une manière holistique et multitâches que les LLMs, limités par des structures contextuelles rigides, ne peuvent imiter.

Ceci met en lumière des limitations déconcertantes : un chat saura instantanément comprendre et s’adapter à son environnement changeant, tandis qu’un LLM se perdra dans des détails sans importance, incapable de réagir aux nuances non codifiées de son environnement. C’est parce que les processus biochimiques qui animent le cerveau des mammifères sont infiniment plus complexes que les calculs algorithmiques qui constituent la base des LLMs.

Les mammifères, y compris les humains, les singes et les chats, possèdent des compétences cognitives remarquables par rapport aux intelligences artificielles actuelles comme GPT. Ils peuvent facilement reconnaître de nouveaux schémas sans supervision, distinguer des modèles complexes avec aisance, et apprendre continuellement sans oublier les concepts précédemment acquis. De plus, ils peuvent identifier des objets avec une grande variation et ont une compréhension innée des formes 3D.

Les humains, spécifiquement, ont la capacité de généraliser des modèles à de nouvelles expériences, appliquer des concepts d’un domaine à un autre, accumuler des connaissances au fil du temps par le biais de l’écriture et du langage, et focaliser leurs efforts sur des récompenses futures grâce à leur capacité de projection dans l’avenir.

Les mythes qui entourent les LLMs

Le moment est venu de déconstruire certains mythes qui entourent les LLMs, comme la faculté supposée de mémoriser. En effet, la « mémoire » des LLMs est limitée aux contextes immédiats, et toute session prolongée peut entraîner des pertes d’information. Cela s’explique par la manière dont ces modèles traitent l’information, de façon contextuelle, sans accès à une mémoire persistante.

Vous avez dû le remarqué : Les modèles peuvent générer des données incorrectes, incohérentes ou entièrement fabriquées, ce qui montre bien les limites de la compréhension de l’IA. Lorsque vous utiliser l’IA générative, elle tente de deviner la suite logique d’une conversation en se basant sur des calculs de probabilités. Parfois, ces calculs produisent des réponses qui semblent logiques pour l’IA, mais qui n’ont pas de sens pour un humain. C’est ce qu’on appelle des « hallucinations ».

L’IA actuelle est souvent perçue comme impressionnante, mais en réalité, elle n’est pas prête à résoudre tous les problèmes, en raison de l’absence de caractéristiques fondamentales.

Les limites de l’IA et les problèmes non résolus à ce jour

L’IA est un modèle d’imitation plutôt que de compréhension. La réalité de ce constat apparaît particulièrement claire quand on considère les avancées des LLMs, qui se heurtent à des limites bien humaines, comme le bon sens ou la capacité d’adaptation au changement.

Professeur Madalina Croitoru, docteure en IA, argumente que l’IA doit évoluer pour intégrer des aspects de l’intelligence émotionnelle et contextuelle humaine, comme la créativité et l’intuition, des éléments encore largement inexploités par la technologie actuelle.

Les êtres humains ont l’avantage d’utiliser leur expérience passée pour prévoir et anticiper les résultats futurs, un domaine où les modèles actuels de l’IA échouent spectaculairement.

Les illusions de progrès rapide en IA persistent alors que certains problèmes majeurs demeurent sous-estimés et non résolus. Beaucoup s’imaginent que davantage de données et de puissance de calcul suffiront pour surmonter ces défis, mais la réalité est plus complexe :

- Actuellement, aucun modèle d’IA ne peut commencer de zéro et apprendre de manière autonome par expérience, excepté quelques systèmes de jeux limités.

- Les modèles actuels ne possèdent pas de représentation interne efficace d’eux-mêmes ou du monde. Ils ne simulent pas des scénarios avant de prendre des décisions.

- L’oubli reste un problème capital : lorsqu’un modèle est ajusté avec des nouvelles informations, il oublie souvent certains apprentissages antérieurs.

- Continuer à apprendre en temps réel est une compétence que nos modèles actuels ne maîtrisent pas. Par exemple, GPT n’adapte pas ses connaissances pendant les interactions, et ne peut apprendre que lors d’entraînements explicites hors ligne.

- Contrairement à la plasticité cérébrale humaine, les modèles d’IA sont statiques depuis leur dernier entraînement.

- Les LLMs ne parviennent pas encore à créer des concepts véritablement nouveaux ou à élaborer des solutions inédites.

- Les modèles IA échouent souvent là où les cerveaux humains réussissent, comme comprendre qu’une seule expérience négative avec un objet coupant s’applique à des objets similaires sans besoin d’exemples répétitifs.

La reconnaissance de variabilité reste également limitée. Contrairement aux animaux qui généraliseront après une unique exposition, les modèles IA ont besoin de nombreux exemples pour se “calibrer”.

Max Bennett illustre ceci en présentant une expérience avec des poissons qui, bien que cognitivement inférieurs en puissance théorique par rapport aux LLMs, réussissent mieux dans des tests de reconnaissance de modèles grâce à leur capacité d’apprentissage par l’expérience directe.

Vers une intelligence générale artificielle (AGI), mais un chemin encore critique vers la super-intelligence

Les experts le savent : Mettre davantage de processeur graphique (GPU) dans les systèmes d’IA ne suffira pas pour atteindre l’AGI, à savoir, une intelligence semblable à celle des humains.

Les modèles actuels permettent aux systèmes de simuler les conséquences de leurs actions, semblables à la manière dont certains animaux agissent intelligemment sans langage complexe. Le développement de « modèles du monde » et de « modèles de soi », qui permettent à une IA de comprendre et prédire ses interactions avec le monde, est nécessaire pour progresser vers la super-intelligence, celle qui dépassera l’intelligence humaine.

Yann LeCun, l’une des voix les plus influentes dans le domaine de l’IA, affirme que

« nous accordons trop d’importance au langage et aux symboles en tant que substrats de l’intelligence ».

En parallèle, Max Bennett dans son livre « A Brief History of Intelligence » recontextualise cette vision en notant que les animaux sans complexes langagiers humains, surpassent aisément nos meilleures IA dans une série d’opérations intuitives.

Nous avons besoin de nouveaux paradigmes algorithmiques que certains, comme Jeff Hawkins dans son livre « A Thousand Brains », explorent déjà.

Les modèles d’IA doivent se doter d’une architecture semblable à celle du cerveau humain : s’inspirer des fonctions cérébrales neuromorphes et se doter d’une neuroplasticité, c’est-à-dire la capacité à s’adapter et à croître avec le temps, pour recréer les capacités dynamiques et adaptatives du cerveau humain.

Contrairement aux modèles traditionnels de deep learning, qui reposent sur des réseaux de neurones artificiels rigides et pré-entrainés, les systèmes neuromorphiques sont bâtis pour refléter la complexité du cerveau avec ses milliards de neurones et innombrables connexions synaptiques.

L’avancée vers une intelligence artificielle comparable nécessitera d’explorer et de reproduire ces mécanismes complexes de simulation et de prédiction, allant bien au-delà des simples augmentations de données ou des nouveautés de performance matérielle.

Le chemin vers une intelligence artificielle générale (AGI) est encore long, bien que Sam Altman, PDG d’OpenAI, dit l’avoir déjà atteint avec son modèle « o3 ».

Pourquoi ? Car nous atteignons déjà un plateau avec les méthodes actuelles. C’est un parcours délicat qui nécessite non seulement des avancées technologiques, mais aussi des innovations en termes de technique, de cognition et de biologie inspirée.

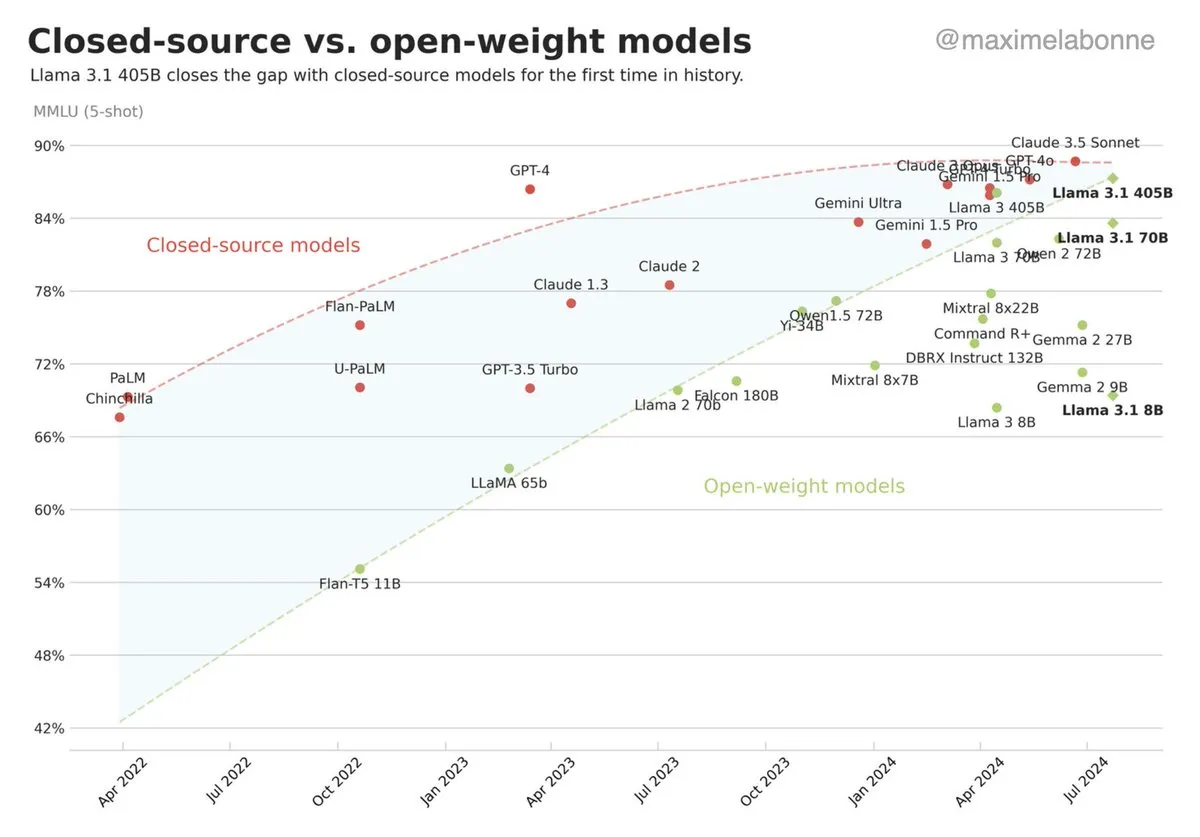

Les modèles Open-Source sont en train de rattraper la performance des modèles fermés, tels que ceux proposés par ChatGPT.

Former l’avenir avec l’IA et le no-code

Dans cette “discipline” en pleine évolution, les écoles émergent comme des accélérateurs du changement. Intégrer l’intelligence artificielle dans nos métiers ne doit pas se faire au détriment de l’intelligence humaine. C’est précisément cette synergie que vise à réaliser Oreegami : préparer les apprenants à devenir des acteurs clés dans la transformation numérique des entreprises, tout en cultivant leur capacité à innover et à collaborer efficacement.

Oreegami propose des formations qui allient maîtrise technique des outils d’IA et développement de compétences transversales essentielles. Les apprenants acquièrent non seulement une expertise pratique en IA, no-code et marketing digital, mais aussi des aptitudes socio-comportementales clés dans l’adoption de l’IA en entreprise, telles que l’esprit critique, l’agilité et l’adaptabilité.

En effet, la pédagogie Oreegami se distingue par son accent mis sur les « fondamentaux humains », souvent négligés dans le discours technologique. Cette approche vise à former des professionnels polyvalents, capables de s’adapter rapidement aux évolutions du marché et de relever les défis d’un monde en constante mutation.

Intégrez un talent IA et Nocode dans votre entreprise

Bénéficiez de collaborateurs rompus aux technologies IA et No Code, un avantage concurrentiel significatif dans les années à venir. Notre équipe vous accompagne dans toutes les dimensions de vos projets IA en équilibrant innovation, rentabilité et responsabilité sociale, et vous guide dans ce nouveau paysage.

Les derniers articles publiés 📢

- NotebookLM : Quand l’intelligence artificielle révolutionne véritablement l’apprentissageUne plongée au coeur du fonctionnement de l’intelligence artificielle, ses capacités actuelles et de ses limites.

- Deep research : combinez la puissance de l’IA avec la recherche web approfondieDeep Resarch : ces agents IA autonomes peuvent effectuer en quelques minutes ce qui prendrait des heures à…

- Jérémy François, l’expert en IA, No-code et Growth MarketingJérémy est en effet à la tête de Self Upgrade, une communauté qui accompagne les entreprises et créateurs de contenu dans leur transformation digitale au travers de formations, du conseil et même un podcast. Cet ambassadeur de Vivatech 2025, qui a à ce jour formé plus de 1 500 professionnels, enseigne l’IA et le no-code chez Oreegami

- Interview de Souraj, expert en data marketing et intervenant chez OreegamiSouraj aborde pour nous les thématiques essentielles pour comprendre la data, telles que la « first party data », la réglementation RGPD, l’optimisation du retour sur investissement (ROI) et des conseils aux entreprises pour mieux exploiter leurs data.